Trong nhiều năm qua, Intel INTC đã mua lại bốn công ty để mở rộng thị trường AI: Nervana, Movidius, MobileEye và Altera. Gần đây nhất Bây giờ công ty đã công bố một chiến lược phần mềm mới đó là Intel OpenVINO để thống nhất các dịch vụ này cho nhà phát triển ứng dụng. Mặc dù vẫn còn nhiều việc phải làm, chiến lược suy luận của Intel có vẻ khá vững chắc và sẽ mở đường cho sự phát triển đáng kể trong AI.

Intel đã thông báo gì?

Chiến lược mới có tên là OpenVINO, tên viết tắt của Open Visual Inference và Neural Network Optimization. Người ta có thể cho Intel vượt qua để bỏ một chữ N nhưng một khía cạnh khác VINO có nghĩa là WINE, – Rượu, không có bất kỳ sự mơ hồ nào. Chúng chúng tôi cảm thất rất thích có mặt tại cuộc họp nơi Intel quyết định xây dựng thương hiệu và sẽ đề xuất một cái gì đó như OpenVIA, cho Tăng tốc suy luận trực quan của Open. Mặc dù vậy, chúng tôi nghĩ chiến lược của Intel là cung cấp giao diện phát triển phần mềm chung cho nhiều công ty phát triển rất nhiều ý nghĩa trong cuộc sống .

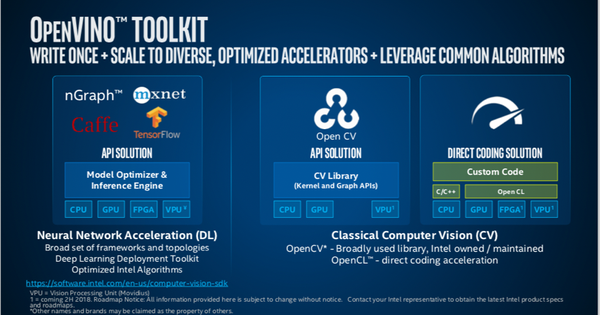

OPENVINO chứa trong bộ công cụ là ba API mới: Bộ công cụ triển khai Deep Learning, bộ công cụ suy luận học sâu (Deep Learning) phổ biến và các chức năng được tối ưu hóa cho OpenCV và OpenVX, với sự hỗ trợ cho các khung công tác TensorFlow, MXNet và Caffe của Machine Learning.

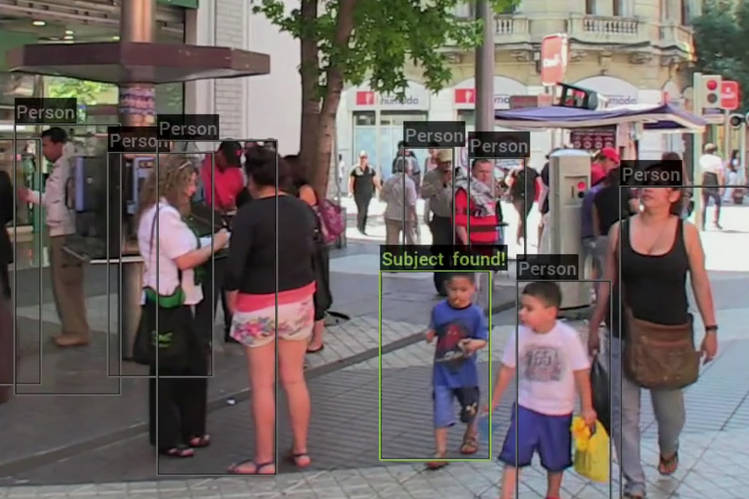

Dưới đây là 1 đoạn clip mô tả nhận dạng hành vi con người bằng OpenVINO ToolKIT

Bộ công cụ OpenVINO cung cấp cho các nhà phát triển phần mềm một bộ công cụ duy nhất cho các ứng dụng muốn có khả năng nhìn giống như con người. Nó thực hiện điều này bằng cách hỗ trợ Deep Learning, thị giác máy tính và tăng tốc phần cứng với sự hỗ trợ không đồng nhất, tất cả trong một bộ công cụ duy nhất.

Intel cho biết bộ công cụ này nhằm vào các nhà data science và nhà phát triển phần mềm làm việc về thị giác máy tính, suy luận mạng thần kinh và triển khai Deep Learning, những người muốn tăng tốc các giải pháp của họ trên nhiều nền tảng, bao gồm CPU, GPU, VPU và FPGA. Điều này sẽ giúp các nhà phát triển đưa trí thông minh thị giác vào các ứng dụng của họ từ cạnh này sang đám mây khác.

Một ứng dụng cụ thể trong giám sát giao thông. Máy ảnh với Intel FPGA và Movidius VPU nắm bắt dữ liệu và tự động gửi nó đến hệ thống giao lộ hạ lưu để giúp bộ phận vận chuyển tối ưu hóa lưu lượng truy cập và kế hoạch. Thông tin này có thể được truyền đạt trực tiếp cho người lái xe thông qua hệ thống xe hoặc ứng dụng để giúp họ lên kế hoạch cho tuyến đường của họ.

Ngoài ra, trong lĩnh vực an toàn công cộng. Với Myriad VPU và các thuật toán được phát triển bằng bộ công cụ OpenVINO, các mạng nơron được đào tạo có thể sử dụng chức năng suy luận để thực hiện phân tích khuôn mặt trên khuôn mặt và xác định trẻ bị mất tích. Các cơ quan thực thi pháp luật thành phố sử dụng công nghệ này có thể nhận được thông báo ngay sau khi tập dữ liệu được đào tạo phù hợp với khuôn mặt của đứa trẻ mất tích trong dân số. Có các ứng dụng không sử dụng trong tự động hóa công nghiệp, tầm nhìn máy, bán lẻ đáp ứng và quản lý hoạt động.

Không chỉ dành cho Intel

Mặc dù rõ ràng rằng Intel đã bao gồm hỗ trợ tối ưu hóa cho phần cứng từ trên xuống dưới của Intel, nhưng hỗ trợ cho API OpenVX cũng cung cấp kết nối không phải của Intel. Bộ công cụ hỗ trợ cả OpenCV và OpenVX. Wikipedia đã tổng hợp hai điều này như sau: Ấn OpenVX bổ sung cho thư viện thị giác nguồn mở OpenCV . OpenVX trong một số ứng dụng cung cấp khả năng quản lý đồ thị được tối ưu hóa tốt hơn OpenCV. Bộ công cụ bao gồm thư viện các hàm, core được tối ưu hóa trước và các cuộc gọi được tối ưu hóa cho OpenCV và OpenVX.

OpenVINO cung cấp các khả năng cụ thể cho suy luận Deep Learning dựa trên CNN ở rìa. Nó cũng cung cấp một API phổ biến hỗ trợ thực thi không đồng nhất trên các máy gia tốc thị giác máy tính: CPU, GPU, Intel Compidius ™ Neural Compute Stick và FPGA.

Có gì mới trong phiên bản Intel OpenVINO R1 2019

- Hỗ trợ bộ xử lý Intel® Xeon® thế hệ thứ hai và cung cấp khả năng tăng tốc hiệu suất để suy luận với Intel® AVX512-Deep Learning Boost.

- Mở rộng hỗ trợ cho macOS * trên CPU cho các thành phần bộ công cụ chính (Trình tối ưu hóa mô hình, công cụ suy luận, OpenCV, v.v.).

- Chuyển các sơ đồ song song từ OpenMP * sang Khối xây dựng luồng (TBB) để cung cấp hiệu suất tăng trong kịch bản đa mạng. Các đường ống triển khai phổ biến nhất chạy nhiều kết hợp mạng và TBB mang lại hiệu suất tối ưu cho các case study này. Để biết thêm chi tiết, hãy xem Khối xây dựng luồng của Intel® dưới dạng song song mặc định.

- Thêm hỗ trợ cho nhiều hoạt động mới trong các khung ONNX *, TensorFlow * và Apache MXNet *. Cung cấp suy luận tối ưu hóa các cấu trúc liên kết như Tiny YOLO * phiên bản 3, DeepLabs * phiên bản 3 đầy đủ và bộ nhớ ngắn hạn hai chiều (LSTM) bằng Bộ công cụ triển khai Deep Learning.

- Bao gồm tám mô hình được xử lý trước cho các case study mới: ước tính ánh sáng, bộ mã hóa nhận dạng hành động, bộ giải mã nhận dạng hành động, nhận dạng văn bản và mạng phân đoạn thể hiện.

- Giới thiệu hỗ trợ cho trọng số nhị phân để tăng thêm hiệu suất và thêm bốn mô hình nhị phân: ResNet 50, và phát hiện khuôn mặt, người và xe.

- Cập nhật plugin FPGA lên Bộ tăng tốc Deep Learning 2019 R1 với các luồng bit mới cho Thiết kế Bộ tăng tốc thị giác Intel®, bộ công cụ dành cho nhà phát triển Intel® Arria® 10 và Thẻ tăng tốc có thể lập trình Intel® với Intel® Arria® 10 GX FPGA. Hỗ trợ lập lịch tự động giữa nhiều thiết bị FPGA.

Cuộc đua của Computer Vision ?

OpenVINO của Intel sẽ giúp thống nhất các dịch vụ CPU, GPU, VPU (Movidius) và FPGA (Altera) đa dạng của họ cho thị trường đang phát triển nhanh chóng để xử lý thị giác. Sẽ rất thú vị để xem nếu điều này kết hợp Nervana và GPU rời trong tương lai. Việc mua lại MobileEye cho các phương tiện tự trị và đào tạo AI của Trung tâm dữ liệu sẽ hoàn thành danh mục đầu tư rộng rãi của Intel để xử lý AI.

Nếu bây giờ Intel có thể duy trì các khóa học, đào tạo và thực hiện chiến lược của mình, chúng tôi tin rằng nó sẽ trở thành đối thủ cạnh tranh đáng gờm trong thị trường lớn hơn để xử lý suy luận. Tất nhiên, gần như không cần phải nói rằng gia đình Intel Xeon vẫn là nền tảng công nghiệp được lựa chọn cho khối lượng công việc AI (Machine Learning cổ điển truyền thống) mà không cần máy gia tốc.

NVIDIA từ trước đến giờ đã trở thành một chuyên gia về chip và hệ thống được sử dụng để đào tạo mạng lưới thần kinh cho các ứng dụng AI, tăng 72% trong quý trước để đạt tốc độ chạy tương lai $ 3B trong đơn vị kinh doanh trung tâm dữ liệu của mình. Tuy nhiên, sự tăng trưởng của xử lý suy luận có thể sẽ lấn át thị trường đó và Intel có rất nhiều công nghệ để mang lại và cạnh tranh cùng NVIDIA trong tương lai. Chúng ta hãy cùng nhau chờ đợi điều này.