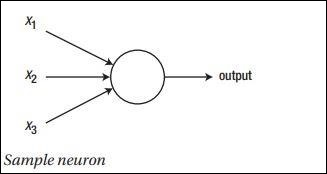

Nguyên tắc chính của mạng nơ-ron bao gồm tập hợp các phần tử cơ bản, tức là nơ-ron nhân tạo hoặc nơ-ron cảm thụ. Nó bao gồm một số đầu vào cơ bản như x1, x2… .. xn , đầu ra nhị phân nếu tổng lớn hơn activation potential.

Biểu diễn sơ đồ của nơron mẫu được đề cập dưới đây:

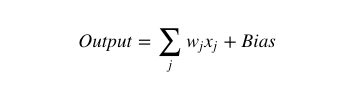

Đầu ra được tạo ra có thể được coi là tổng có trọng số với activation potential hoặc độ lệch(bias).

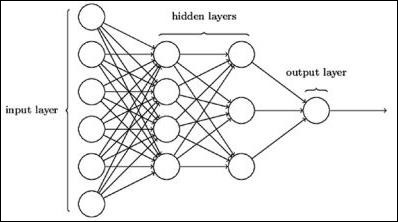

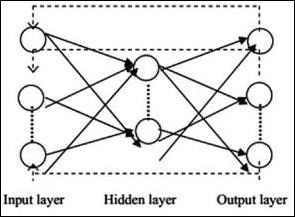

Kiến trúc mạng nơ-ron điển hình được mô tả như sau :

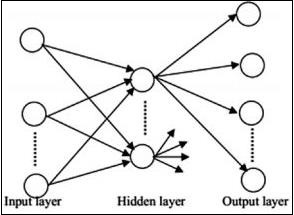

Các lớp giữa đầu vào và đầu ra được gọi là các lớp ẩn(hidden layers), mật độ(density) và kiểu kết nối giữa các lớp là cấu hình(configuration). Ví dụ, một cấu hình được kết nối đầy đủ có tất cả các tế bào thần kinh của lớp L được kết nối với các tế bào thần kinh của L + 1. Để rõ ràng hơn, ta chỉ có thể kết nối một vùng lân cận cục bộ, chẳng hạn như chín tế bào thần kinh, với lớp tiếp theo. Hình 1-9 minh họa hai lớp ẩn với các kết nối dày đặc.

Các loại mạng nơ-ron khác nhau như sau:

Recurrent Neural Networks (RNN)

RNN là khi mẫu dữ liệu thay đổi do đó trong một khoảng thời gian. Trong RNN, cùng một lớp được áp dụng để chấp nhận các tham số đầu vào và hiển thị các tham số đầu ra trong mạng nơ-ron được chỉ định.

Mạng nơ-ron có thể được xây dựng bằng package torch.nn.

Đây là một mạng chuyển tiếp đơn giản. Nó lấy đầu vào, nạp lần lượt qua nhiều lớp, rồi cuối cùng đưa ra đầu ra.

Với sự trợ giúp của PyTorch, ta có thể sử dụng các bước sau cho quy trình đào tạo điển hình cho mạng nơron:

- Xác định mạng nơ-ron có một số tham số (hoặc trọng số) có thể học được.

- Lặp lại tập dữ liệu đầu vào.

- Xử lý đầu vào thông qua mạng.

- Tính toán loss (kết quả đầu ra chính xác đến đâu).

- Truyền chuyển màu trở lại các thông số của mạng.

- Cập nhật trọng số của mạng, thường sử dụng một bản cập nhật đơn giản như dưới đây

rule: weight = weight -learning_rate * gradient